- Für die Reise habe ich auf tutti.ch für 150.- ein 10 jähriges 11″ MacBook Air gekauft, damit ich mein 7-jähriges MacBook Pro mit 13“ nicht mitschleppen muss ;) Der Läppi verwende ich zum Sichern aller gemachten Fotos in iCloud (2 Nikon Coolpix der Kids und meine Lumix, Die beiden iPhones der Eltern sichern sich selber in die iCloud). Ab und zu mache ich auf dem Ding auch etwas mehr als Fotos angucken, z.B. ein Hotel buchen oder etwas Mails lesen.

- Fürs Internet unterwegs habe ich eine eSIM von Airalo gekauft (5 GB für ein Monat Costa Rica), die normalen Galaxus Mobile Handy-Abos werden für die Zeit in den USA auf ‘International’ aufgerüstet, und danach wieder auf ‘CH unlimitiert’ runterskaliert.

- Bus fahren in Costa Rica geht sehr gut mit Moovit. Nicht ganz so gut wie die SBB-App, aber immerhin… Wenn‘s mal nicht klappt, dann ist ein Taxi oder gar ein Uber nicht weit. Die Busse fahren erstaunlich pünktlich, heute haben wir in Jacó auf den Bus aus San José (der fährt da schon 4-5 h) nur 25 Minuten gewartet.

- OrganicMaps befüllt mit OpenStreetMap-Daten hilft bei der Navigation, immer und überall. Meine Änderungen in Costa Rica bringen mich hier aktuell auf den 10. Rang, und helfen den nächsten Menschen, die hier OpenStreetMap benutzen.

- Die ungefähre Route wird automatisch vom “Diary-Modus” von myTracks auf dem Telefon aufgenommen, die GPX-Tracks landen via iCloud, der myTracks-Mac-App und dem GPX Viewer-Plugin für WordPress unten an den Wochenrückblick-Posts. Die Herzensdame führt ein Polarsteps-Tagebuch, wer dort mitlesen will, muss sie selber fragen.

- Mein ganz persönliches Tagebuch mit Notizen zu jedem Tag landet (das schon seit Jahrzehnten, aber das nicht jeden Tag) in Day One, aktuell nur auf dem Telefon, für 3$ im Monat ginge das auch mehr-gerätig.

- Alle Dokumente landen in meinem paperless, das dank elest nicht auf einem NAS zuhause läuft, sondern für 10$ im Monat irgendwo in einem Hetzner-Rechenzentrum (Danke an Bastian fürs „Gegenlesen” meiner Fragen dazu).

- Unsere Wohnung ist dank dem Untermietservice fast die ganzen 100TageFurt an eine Familie mit Kindern vermietet, die auch unsere Pflanzen giesst. Dass das so gut passt, ist ein grosses Glück.

- Dank ePost müssen die Untermieter nicht mal unseren Briefkasten leeren, alle Post bekommen wir für die drei Monate für 10.- im Monat als PDF in der ePost-App.

personal

There are 611 posts filed in personal (this is page 2 of 31).

#100TageFurt Woche 3: Von Puerto Viejo zu Puerto Viejo

In Cahuita machen wir zwei längere Spaziergänge im Nationalpark, dessen einziges Promlem ist, dass er schon um 16:00 schliesst. Der Strand im Nationalpark ist paradiesisch und verhilft zu vollem Karibikfeeling. Nur die Snacks müssen von den anwesenden Affen und Waschbären beschützt werden, sind aber schnell selbst gegessen.

Nach ein paar Tagen Cahuita fahren wir kurz mit dem Bus nach Puerto Viejo, fast schon in Panama. Das Hotel mit Beachfront im Namen ist nur durch eine Strasse vom Strand getrennt.

Die Permakulturfarm, die wir besuchen wollten, um ein paar Tipps für den Schrebergarten zu holen ist leider nicht mehr besuchbar und von zwei aggressiven Schäferhunden bewacht. Zum Glück sind das die einzigen Aggro-Hunde, die wir bis jetzt gesehen haben, alle anderen (Strassen)Hunde sind sehr chill. Leider ist aber streicheln tabu, weil die Tollwut-Impung zuhause nicht mehr erhältlich war…

Am nächsten Tag schaffen wir es knapp rechtzeitig zu Ara Manzanillo, v.a. weil der Wegweiser dazu auf OpenStreetMap ca. 1.5 km vom Treffpunkt für den Besuch weit weg ist. Die Ara-Aufzuchtstation hat ein lustiges Eintritts-System; gegen eine Spende kann mensch dort rein. Die Reservation geht über die Webseite und die Spende ist nur im Umfang von 20$ möglich ;) Dafür sehen wir hunderte Aras, die um uns über unsere Köpfe schwirren und lernen etwas über deren Leben. Kind2 ist ganz konsterniert, dass seine Lieblingsvögel (Tukane), die Eier seiner zweitliebsten Vögel (Aras) essen und nicht mehr sicher, ob Tukane seine Lieblibgsvögel sind. Mit dem Bus und dem ganzen Team der Aufzuchtsstatuon fahren wir nach Puerto Viejo zurück, während alle anderen Touris sich in die klimatisierten Autos zurückziehen und irgendwo hinfahren.

In Puerto Viejo baden wir viel (und springen von kleinen Wracks am Strand) und geniessen die Annehmlichkeiten einer grossen italienischen Diaspora, wie tolle Gelati und Spaghetti wir beim Nonno.

Am Tag 18/100 fahren wir von Puerto Viejo im Süden nach Puerto Viejo neben Sarapiqui und checken im Hotel Bambú ein. Das liegt unmittelbar neben dem Busterminal, zum Glück sind die Zimmer sind auf ca. 200m langen Brücken erreichbar und liegen mitten im Dschungelwald.

Sarapiqui bietet als Stedtli leider überhaupt nix, aber etwas ausserhalb finden wir eine tolle Kakao-Tour, wo wir viel über die richtige Art Kakao lernen, und nicht die Art, die wir in der Schweiz in der Schoggi haben. Der Costa-ricanische Kakao wird im Gegensatz zu den afrikanischen Kakao-Bohnen ungefähr eine Woche fermentiert [1], was jegliche Bitterkeit entfernt. Glücklicherweise konnten wir Kakao von jedem Produktionsschritt probieren und beenden die Tour Theobromin-gesättigt.

Am nächsten Tag fahren wir zur Tirimbina, einem schönen Naturreservat mit der längsten Hängebrücke in Costa Rica. Die Wanderwege/Trails sind kurz und knackig, wir sehen hier vor allem kleinere Tiere, und keine Affen und Faultiere wie anderswo.

Am Tag 21/100 fahren wir mit einem Doppeldeckerbus (toll vorne oben, aber sehr sehr heiss) nach La Fortuna, wo wir ein paar Nächte stationiert bleiben.

[1] Ich hab ja mal gelesen, dass die Fermentierung uns Menschen so erfolgreich machte, und nicht die Zähmung des Feuers.

#100TageFurt Einblick: Faultier-Sicherung

In Cahuita kletterte ein Faultier an der Telefonleitung über die Strasse. Da musste die Mama mit Baby gesichert werden.

#100TageFurt Woche 2: Welcome to Costa Rica

Nachdem der drei Stunden zu späte Flug für umplanen beim ersten Bus gesorgt hat (stattdessen ein Uber zum Busbahnhof) sind wir mit einer Übernachtung unterwegs beim Tortuguero Nationalpark angekommen.

Die Lodge, in der wir schlafen ist sehr cool und abgelegen, die Essensauswahl beschränkt sich auf “Chicken, Fish from the sea or from the river, Vegetarian”. Von der Lodge aus erklimmen wir einen erloschenen Vulkangipfel, was – obwohl es nur 120m Höhenunterschied ist – wegen der hohen Temperaturen und Luftfeuchtigkeit ziemlich streng ist. Der Ausblick auf den Regenwald und den Natonalpark entschädigt aber für jede Anstrengung. Viel weniger anstrengend war dann der Jaguar-Trail am nächsten Tag. Dieser Trail war als anspruchsvoll im Reiseführer, das anspruchsvollste daran war das Öffnen der Kokosnuss frisch von der Palme, der Trail war 3 km füre dem Strand entlang (20 m im Wald drin) und 3 km wieder zrügg.

Nach 4 Nächten dort sind wir mit dem öV-Boot 3h der Küste entlang gefahren und mit dem Bus weiter nach Cahuita. In Cahuita lodegierten wir in den Iguana-Kabinen, die von Cousin meiner Schwiegermutter geführt werden, der die Schweiz vor ca. 40 Jahren militärdienstverweigernd verliess.

In Cahuita geniessen wir langsame Tage am Pool und im Meer und testen die verschiedenen Restaurants im Stedtli.

#100TageFurt Woche 1: Welcome to Miami

Abgesehen davon, dass wir am ersten Tag eine Sonnenbrille im Meer verloren haben, und die Sonne grob unterschätzten, war diese Woche in Miami sehr erholsam.

Am Hotel-Pool haben wir Iguanas gesehen (einer davon kurz auch im Pool) und am Strand einige (zum Glück tote) portugiesische Galeeren. Miami hat lustige kostenlose Busse und ein Publibike-Äquivalent, so dass wir in einer Klischee-Amerika-Stadt ziemlich mobil waren.

Mit einem gemieteten Auto fuhren wir dann zwei Mal zu den Everglades. An einem Tag krass touristisch mit Alligatorenfarm und danach einem “Trail“, der sich als asphaltierten Weg und Holzbrücke mit einer insgesamten Länge von etwa 1.5 km herausstellte. Wenigstens war die “Möglichkeit zum Tiere beobachten” nicht zuviel versprochen und wir konnten neben dem Weg viele Schildkröten (teilweise riesig), zwei Alligatoren und eine Vielzahl von Vögel beobachten. Am anderen Tag fuhren wir etwas mehr ans Meer, wo wir im Homestead Bayfront Park eine tolle Kanutour um und im Mangrovenwald machen konnten.

Heute Morgen sind wir mit demselben o Mietauto von Miami Beach an den Flughafen in Fort Lauderdale gefahren, haben das Auto dort deponiert und sitzen jetzt im (arg vespäteten) Flugi nach San Jose in Costa Rica.

Ich bin dann mal #100TageFurt

Uff.

Die letzten Wochen waren doch etwas mehr ein Gjufu als geplant. Aber trotzdem: Wenn alles nach Plan verläuft, sind wir genau jetzt in der Luft und kommen erst in 100 Tagen wieder zurück.

Schon seit längerem überlegen wir an einer Auszeit rum und konnten diese aus verschiedenen Gründen jetzt realisieren. Nina hat nach 12 Jahren beim gleichen Arbeitgeber ins Blaue raus gekündigt (die Story wie es dazukam füllt fast ein Buch und hat hier nicht zu suchen), ich kann dank einem tollen Arbeitgeber und einem tollen Team 10 Wochen unbezahlten Urlaub und einige Ferientagen auf 100 Tage Abwesenheit ausdehnen und die Kids konnten wir für ein Quartal von der Schule abmelden. All das zusammengesetzt macht es möglich, dass wir heute in ein grosses Abenteuer starten.

Zum Start unserer 100-tägigen Auszeit verbringen wir eine Woche in Miami, in den USA. Neben Ankommen und auf die nachreisende Seele warten werden wir dort vor allem Baden, Velo fahren und rausfinden, ob in den Everglades Alligatoren zu sehen sind.

Nach einer Woche in Miami fliegen wir weiter nach San José in Costa Rica und werden in ziemlich genau einen Monat die Gegensätze des Landes aufsaugen. In der Hoffnung, dass mein Duolingo-Streak von jetzt fast 100 Tagen Spanisch hilft, nahe an den Einheimischen zu sein, versuchen wir uns nur mit den öffentlichen Verkehrsmitteln (also vor allem Bussen) durch das Land zu bewegen. Viele Pärke und Lodges in der Natur werden viele Wanderungen ermöglichen und auch lange Nachmittage an einem Strand oder an einem Pool.

Nach einem Monat Costa Rica fliegen wir nach Los Angeles, wieder in den USA, diesmal aber an der Westküste. Dort werden wir ein paar Tage lang die Stadt erkunden, bevor wir den zweitkleinsten (und günstigsten) Camper in der IndieCampers-Flotte und auf vielen Umwegen in 53 Tagen nach San Francisco fahren. Die direkte Strecke dauert nur ca. 6 1/2 Stunden, wir fahren aber weit neben der optimalen Strecke durch. Wir werden nämlich versuchen, in viele Nationalpärke zu fahren und dort die Hügel und Berge geniessen und für die Kids praktischen NMG-Unterricht zu machen. Gegen Ende unserer Reise besuchen wir einen Gymerkollegen von mir, der Ende 2023 nach fast 2 Jahrzehnten bei Google gekündigt hat und werden ein paar Tage durch San Francisco spazieren und die Stadt kennenlernen, so gut es als Tourist geht.

Mitte Juli fliegen wir dann von San Francisco wieder nach Hause.

Während der Zeit werden ich versuchen, ab und zu hier mal etwas von unserer Auszeit zu erzählen, evtl. wird es also auch mal etwas persönlicher als in den letzten Monaten und Jahren.

Bis gly!

Recommended Readings vom Februar 2024

Im letzten Monat las ich folgende Texte und fand diese gut:

- Blood, Guns, and Broken Scooters: Inside the Chaotic Rise and Fall of Bird (wired.com) : Diese Miet-Elektro-Trotti-Geschichte ist nicht immer ganz so einfach wie’s aussieht.

- Der Bund überwacht uns alle (republik.ch) : Vor der Abstimmung zum Nachrichtendienstgesetz versprach der Bundesrat: Eine flächendeckende Überwachung der Bevölkerung wird es nicht geben. Doch heute ist die Kabelaufklärung genau das: ein Programm zur Massenüberwachung.

- Wishful bio weapons (tante.cc) : Über die Diskussion, dass künstliche Intelligenz Biowaffen generieren könnte. Und dass das nur eine Ablenkung vom wirlkichen Problem ist. Die meisten negativen Folgen irgeneiner künstlichen Intelligenz sind direkte Folgen von Kapitalismus. Dagegen kann mensch weniger machen als gegen hallzuzinierte Biowaffen.

- OPML is underrated (kmaasrud.com) : Das OPML-Format ist praktisch, um RSS-Feeds auszutauschen. Ich lese meine Feeds immer noch mit Fever° und Reeder, auch wenn die Fever schon seit Jahren nicht mehr unterstützt wird. Item, wen’s interessiert, findet hier eine OPML-Datei aller meiner RSS-Feeds.

- A Teen’s Fatal Plunge Into the London Underworld (newyorker.com) : Zac Brettler sprang in London von einem Balkon. Die Untersuchung des Suizides zeigt eine tiefer gehende Geschichte, die so weit geht, dass der englische Mitteklasse-Jugenliche sich als Sohn eines russischen Oligarchen ausgab.

- What happens when an astronaut in orbit says he’s not coming back? (arstechnica.com) : “Was ist der stressigste Tag für eine U-Boot-Besatzung? Der Tag der offenen Tür!”

Im letzten Monat sah ich folgende Videos und fand diese gut:

Falls ich nächstens dort mal selber vorbeikomme, werde ich die breiten Strassen genauer anschauen.

Wo war ich im 2023?

Hier einer der Posts zu meinem 2023. Dieser und andere Posts sind unter dem Tag jahresrückblick23 zu finden.

Christian hat mich daran erinnert, dass ich noch darüber schreiben wollte, wo ich dieses Jahr war.

Dank dem ‘Premium’-Abo von WHIB habe ich einen Überblick der Positionen meines Telefons während der letzten 5 Jahre in einer CSV-Datei, die mit etwas Python-Code einfach auswertbar ist.

Schlussendlich habe ich 20700 Datenpunkte mit einer Position im 2023.

Ich schalte mein Telefon in der Nacht aus, also habe ich im Schnitt (bei 8h ausgeschaltetem Telefon) ca. alle 20 Minuten einen Datenpunkt.

Im Sommer sind wir mit unserer fahrenden Ferienwohnung an der Atlantikküste gewesen, haben auf lustigen, eigentlich privaten Campingplätzen übernachtet und viel unsere mitgenommenen Velos bewegt.

Im Herbst haben wir die Nordostküste von Sardinien befahren und waren so viel wie möglich nicht auf Campingplätzen, sondern haben am Strand übernachtet, bis der Strom und Kühlschrank leer und das WC voll waren.

Wir sind insgesamt 910 km in Nord-Süd, und 893 km in Ost-West-Richtung unterwegs gewesen.

Im Median war ich auf dem Bänkli beim Elefantenspili.

Am nördlichsten waren wir etwas südlich von Paris, auf der Autobahn, am östlichsten irgendwo südlich von Bastia in Korsika (wo wir nicht waren, und sich wahrscheinlich mein Handy bei der Fährüberfahrt von Genua nach Porto Torres eingebucht hat), am südlichsten irgendwo nach 3 Nächten am schönsten Strand von Sardinien (Is Arutas, der uns von zwei wunderbaren alten Menschen ein paar Nächte vorher empfohlen wurde), am westlichsten irgendwo auf dem Weg zum Strand auf Noirmoutier.

Der höchste Punkt war zum Start in die Skisaison vor gut einem Monat auf dem kleinen Matterhorn in Zermatt.

Unten ist die Heatmap meiner Positionen im 2023 eingebunden, so dass Reinzoomen in die Karte und Raussuchen anderer Ausflüge selbst möglich ist.

Die komplette Analyse ist auf GitHub zu finden, falls jemand dies für sich nachbauen will.

Weil die Originaldatei mit meinen Positionen auch die genauen Zeiten enthält, liefere ich die aus datenschutztechnischen Gründen nicht mit.

Eine komplette Version meiner Analyse als Notebook mit allen Karten ist dank dem coolen NBViewer hier zu sehen.

Der nächste Jahresrückblick wird dann noch etwas spannender.

Wir planen von Mitte April bis Mitte Juli eine grosse Auszeit und werden mit den Kindern Nationalpärke auf einem anderen Kontinenten besuchen.

Happy 2024

Die diesjährige Neujahrskarte ist auf einem Sonntagsspaziergang entstanden1.

Mit dem Stativ, der Nikon D7000 und dem Sigma 10-20mm Weitwinkel-Objektiv habe ich ein paar Fotos von uns gemacht.

Zusammengebastelt in hugin2 und finalisiert in Pages.

Eigentlich wollte ich das 2, 0, 2, 4-Schema noch mit im Himmel fliegenden Buchstaben illustrieren, aber trotz einigen Blender–Tutorials habe ich das dann doch nicht so hübsch hinbekommen wie geplant.

Die Printzessin hat kurz vor Weihnachten die physischen Postkarten gedruckt, einige davon gingen auf die Post, 23 Stück habe ich gestern so verradelt.

In diesem Sinne; “Happy 2024” allen, die hier mitlesen.

Häbit Sorg, leget e Maske a und blibet gsung!

- Wo genau ist quasi eine Geoblog-Frage.

Antworten gerne in den Kommentaren. ? - Welches für macOS schon lange nicht mehr aktualisiert wurde, aber trotzdem noch läuft.

Die gegenwärtig aktuellste Version ist hier verfügbar (via hugin Mailingliste). ?

National- und Ständeratswahlen 2023

Wie noch jedes Mal ist die Wahlempfehlung für die National- und Ständeratswahlen dank smartvote flink zusammengestellt. Wie auch jedes Mal landet Erich Hess auf den hinteren Plätzen (diesmal wieder auf dem drittletzen Platz).

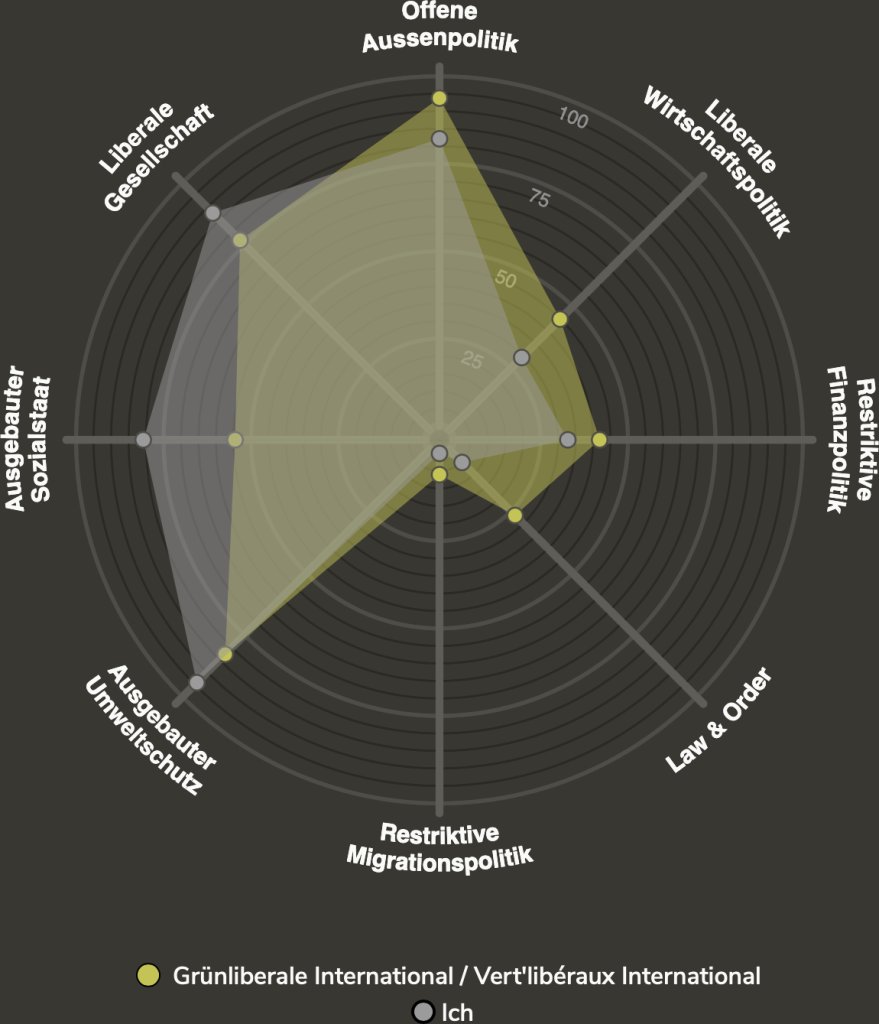

Die Liste “Grünliberale International” stimmt diesmal am Besten mit meinen Antworten überein.

Aus Einfachheitsgründen landet diese Liste dieses Mal auch in der Urne.

Kurzkritik: Asteroid City

Ein Film mit Tilda Swinton ist immer sehenswert.

Wenn sie dann noch in einem Film von Wes Anderson mitspielt, ist der Film doppelt sehenswert [1].

Asteroid City bricht die vierte Wand im doppelten Sinn und ist ein Film über ein Theaterstück mit Aliens.

Ein Schaulaufen von berühmten Gesichtern erfreut das Herz.

Viele Einstellungen in wunderbaren Farben, die wohl mit dem Lineal durchgeplant wurden erfreuen das Auge.

Das “Fäden-im-Kopf-behalten” und die vielen tollen Details erfreuen den Kopf.

[1]: Genau wie Moonrise Kingdom und The Grand Budapest Hotel. The French Dispatch ist in der filmischen ‘ToDo’-Liste.

Recommended Readings vom April 2023

Im letzten Monat las ich folgende Texte und fand diese gut:

- Notes from a Long COVID hermit (pieceoplastic.com) : Und es gibt immer mehr Menschen, die sagen ‘die Pandemie ist vorbei’. Sone Kack.

- I don’t want streaming music, I just want to stream my music (coryd.dev) : Ich will eigentlich ja nur immer Zugriff auf alle meine Musik haben, und nicht für Spotify zahlen.

- Social Media is a Major Cause of the Mental Illness Epidemic in Teen Girls. Here’s The Evidence. (jonathanhaidt.substack.com) : Gut fundierte Zusammefassung über den (extrem negativen) Zusammenhang von Social Media und mentaler Gesundheit bei jungen Frauen. Macht mir persönlich viel Gedanken beim Blick in die Zukunft von Kind1.

- Maybe Treating Housing as an Investment was a Colossal, Society-Shattering Mistake (goodreason.substack.com) : Wir wohnen in Miete. Und werden das auch weiterhin tun.

- What Colour are your bits? (ansuz.sooke.bc.ca) : Ziemlich theoretischer, aber auch ziemlich cooler philosophischer Text über Copyright.

- Ihme-Zentrum in Hannover: Der geborstene Gigant (taz.de) : Ein Investor lässt das Ihme-Zentrum in Hannover verfallen. Nun zieht die Stadt als Mieterin aus. Ist der Koloss noch zu retten?

- Ich sehe blau und gelb (daslamm.ch) : 66% unseres Teams sind in der Ukraine geboren. Ich sehe nicht ganz so blau und gelb wie Emilia Sulek, aber fast.

- If we lose the Internet Archive, we’re screwed (sbstatesman.com) : “The Internet Archive is good for literacy. It’s good for the public.” Wer etwas Geld zum Spenden übrig hat, soll dorthin ‘was spenden. Oder in die Ukraine.

Im letzten Monat sah ich folgende Videos und fand diese gut:

Da baut einer einfach ein durchsichtiges Turbinentriebwerk.

So kontrollierten die Hersteller die Belichtungszeit von mechanischen Fotoapparaten.

Falls jemand von euch mal seinen Bohrer in einem SEM anschauen will, kann ich mit Kontakten helfen :)

Ich kann’s ja überhaupt nicht mit Fussball, aber dass Barbados mal in einem Spiel extra ein Eigengoal gemacht hat, finde ich schon eine lustige Geschichte.

Wie Wasser ein Labyrinth lösen kann.

Wie Elektronen ein Labyrinth lösen können-

Abteilung Korinthenkackerei

Liebes Inselspital.

Die neue Durchfahrt durch dich ist sehr hübsch geraten, dass dieses unsägliche rote Stahlgestell weg ist, macht die Durchfahrt hell und angenehm.

Diese Brücke vom Kinderspital rüber in den Neubau ist eindrücklich.

Aber; irgendwie ging beim Anschreiben etwas schief, wortwörtlich.

Wenn ich das Foto nehme und die Brücke horizontal mache (siehe die beiden roten Markierungen [1], dann ist die Schrift (grün markiert [2]) dazu gemessene 1.1° schief.

Ist das äxtra so?

[1]: OK, so gerade wie geht, nämlich oben -0.331° und unten 0.475°, im Mittel 0.144°

[2]: Oben -1.121° und unten -0.762°, im Mittel also -0.942°. Macht summa summarum 1.0855°

Recommended Readings vom März 2023

Im letzten Monat las ich folgende Texte und fand diese gut:

- PR as open letter (tante.cc) : Jürgen Geuter schreibt über den offenen Brief des Future Of Life-Instituts, welcher eine Pause für AI-Experimente fordert. Eine sehr gute Einordnung.

- Approximating pi using… a cake? (ntietz.com) : In der biomedizinischen Forschung gib’t das Fachgebiet der Stereologie, wo anhand Schnitte durch ein Material dessen charakteristische Parameter genau abschätzen lassen. Mit Kuchenstreuseln lässt sich ? erstaunlich genau bestimmen.

- Das Netzwerk der Jungen Rechten (antifa.ch) : Die Antifa beleuchtet ein Netzwerk zwischen Junger SVP, der Identitären Bewegung und der Jungen Tat.

- Der Saubermann der Verschwörungsszene (antifa.ch) : Protest gegen umstrittenen Historiker Daniele Ganser. Daniele Ganser geht auf Vortragstour. In einigen Städten gab es bereits Protest gegen seine Auftritte – teilweise mit Erfolg. Im Gegensatz zu anderen seines Metiers schafft er es weiterhin, als »umstrittener Historiker« ganze Hallen zu füllen.

- Folgen der Inflation: Eine Plastiktüte voll Rechnungen (taz.de) : Brot, Gas, Socken, alles ist teurer geworden. Was heißt das für Menschen, die sowieso schon wenig haben? Ein Tag in einer Sozialberatung in Deutschland.

- Wie der russische Panzer nach Berlin kommt (berlinstory-news.de) : Eine schöne Geschichte eines sturen Bocks. Wie es Enno Lenze und sein Team geschafft haben, zum Jahrestages des Kriegsbeginns in der Ukraine einen zerstörten russischen Panzer in Berlin vor der russischen Botschaft hinzustellen.

- Lessons learned from 15 years of SumatraPDF, an open source Windows app (blog.kowalczyk.info) : Zwischendurch arbeite ich im Büro auf Windows-Maschinen; SumatraPDF ist dort immer mal wieder im Einsatz.

- The rise and fall of peer review (experimentalhistory.substack.com) : Über das sog. PeerReview, um das Wissenschaftler:innen (leider) nicht rumkommen1. Ein eigentlich gescheitertes Modell, das aber nur extrem langsam geändert wird. Der zweite Teil der Story ist auch sehr lesenswert.

- Can AI write good novels? (theverge.com) : Über die komische Welt von semiautomatischem (oder AI-unterstütztem) Schreiben von Büchern. Da lese ich doch lieber kürzere Essays, z.B. eines von Urs über Lentille, die Kuh.

Im letzten Monat sah ich folgende Videos und fand diese gut:

Barbados tönt nach einer tollen Feriendestination.

Aber der Verkehr dort ist unglaublich.

Dieses Video erklärt die Hintergründe.

- Letzthin hat ein Reviewer für ein Manuskript tatsächlich verlangt, dass die 3D-Visualisierungen der winzig kleinen fossilen Muschel um ca. 3° gedreht werden, damit diese “schöner” aussehen… ?

Wo war ich im 2022?

Hier einer der Posts zu meinem 2022.

Dieser und andere Posts sind unter dem Tag jahresrückblick22 zu finden.

Dieses Jahr haben wir uns mehr als andere Jahre in einem Fahrzeug bewegt.

Das ist eine längere Geschichte; kurz zusammengefasst sind wir seit Ostern Besitzer eines ziemlich grossen Fiat Ducatos, der sich auch als Camper identifiziert.

Das hat zur Folge, dass wir an einigen noch unbekannten Orten in der Schweiz waren und dort lustige Tage und Wochenenden verbracht haben.

Wie schon ein paar Jahre habe ich dank dem ‘Premium’-Abo von WHIB einen Überblick der Positionen meines Telefons während des ganzen Jahres in einer CSV-Datei.

Schlussendlich habe ich 23500 Datenpunkte mit einer Position im 2022.

Ich schalte mein Telefon in der Nacht immer aus, also habe ich im Schnitt (bei 8h Telefon ‘off’) ca. alle 15 Minuten einen Datenpunkt.

Aufgrund der Sommerferien an den Dolomiten und den Herbsferien in Sardinien sind wir fast 400 km in Ost-West-Richtung und knapp 800 km in Nord-Süd-Richtung unterwegs gewesen.

Im Median war ich im Beachcenter Bern, nämlich als ich dort Festbänke und Tische für unser Strassenfest abholte.

Am nördlichsten wiederum in Basel, am östlichsten in San Giovanni di Fassa neben Bolzano, am westlichsten in der Nähe von Lausanne und am südlichsten in Urzulei in Sardinien.

Der höchste Punkt war zum Start in die Skisaison vor einem Monat auf dem kleinen Matterhorn in Zermatt.

Unten ist die Heatmap meiner Positionen im 2022 eingebunden, so dass Reinzoomen in die Karte und Raussuchen anderer Ausflüge selbst möglich ist.

Die komplette Analyse ist auf GitHub zu finden, falls jemand dies für sich nachbauen will.

Weil die Originaldatei mit meinen Positionen auch die genauen Zeiten enthält, liefere ich die aus datenschutztechnischen Gründen nicht mit.

Eine komplette Version meiner Analyse als Notebook mit allen Karten ist dank dem coolen NBViewer hier zu sehen.

Kurzkritik: Bullet Train

Ein (sehr) hübsches Kammerspiel, nicht nur für Ferro-Sexuelle.

Sehr viele Fäden laufen zu einer actiongeladenen Geschichte zusammen.

Recommended Readings vom Dezember 2022

Im letzten Monat las ich folgende Texte und fand diese gut:

- Voll ins Auge (republik.ch) : Mindestens einmal pro Jahr wird in der Schweiz ein Mensch von einem Gummigeschoss schwer verletzt. Trotzdem setzt die Polizei oft und erstaunlich breit auf das umstrittene Einsatzmittel. Kritik daran gibt es kaum. Anders als früher.

- Némésis Suisse (antifa.ch) : Seit über einem Jahr ist in der Westschweiz eine Gruppe der rechts-feministischen Bewegung Némésis aktiv und hetzt gegen Migrant:innen. Die Antifa Bern schaut da mal genau hin.

- Rechtsextremismus: Die Schwiegersohn-Neonazis (woz.ch) : Die Junge Tat versucht ihre Themen in die Mitte der Gesellschaft zu tragen. Woher die Gruppe kommt, wie sie sich verorten lässt, wer die Köpfe dahinter sind.

- Beware of the Perfect Gentleman (vice.com) : Die Männer, deren Fotos für gefälschte Onlineprofile verwendet werden, haben kaum eine andere Möglichkeit, als ständig gefälschte Profile auf Social-Media-Plattformen zu melden.

- Digital detritus (lcamtuf.substack.com) : Ich muss glaub’ 1SecondEveryday wieder installieren.

- Things I’ve noticed while visiting the ICU (trevorklee.substack.com) : (nur noch auf archive.org zu finden) Was in einer Intensivstation vor sich gehen kann.

- The Origins of Python (inference-review.com) : Ein bisschen Computer-Historie.

Im letzten Monat sah ich folgende Videos und fand diese gut:

Die “Anastasia-Bewegung” ist eine völkisch-religiöse Sekte, die in Brandenburg und im Harz Häuser und Grundstücke aufkauft.

Nach aussen hin geben sie sich harmlos.

Doch ihre Ideologie ist gefährlich.

Nicht nur in Deutschland, sondern ‘neu’ auch in der Schweiz, siehe drüben bei den Betonmalerinnen.

Happy 2023

Die diesjährige Neujahrskarte ist komplett am Computer entstanden.

Mit der Hilfe von Midjourney1 und Inputs2 von K1 und K2 entstanden angelehnt an ein Familienfotos von uns saisonale Fotos einer geträumten Familie.

Zusammegefügt mit etwas Text und gedruckt auf physische Postkarten gingen diese dann vor ein paar Tagen auf die Post.

In diesem Sinne: Häbit es guets Nöis!

- Midjourney ist aus meiner Sicht die beeindruckendste Inkarnation von geträumten Computer-Ideen. Jedenfalls macht es aus meinen Inputs beeindruckend coole Bilder ?

-

Übersetzt von mir zu den Prompts

a family of four on a grassy plain in spring, with flowers and dinosaurs in the background, on shots of famous documentary photographers --v 4,[...] at the beach in summer, with lots of blow up toys, and a flamingo in the background [...],[...] in the woods in autumn, with large planets in the sky [...]und[...] in the wintery mountains, in the background a herd of bicycles [...]. ?

Recommended Readings vom Juli und August 2022

Anfangs August waren wir irgendwo in der Region des Nationalparks, irgendwie komplett offline und ich hab’ die ‘recommended readings’ nicht generiert.

Deshalb hier die guten Texte aus Juli und August, viele im Aufstelldach des Campers auf dem Kindle gelesen:

- How Standard Ebooks serves millions of requests per month with a 2GB VPS; or, a paean to the classic web (alexcabal.com) : Eine Ode an einfach Webseiten. Standard Ebooks läuft mit sehr einfachen Mitteln tipop. Und macht schöne eBücher, die legal runtergeladen und gelesen werden können.

- I Loved Bike Touring—Until I Got Paid to Do It (outsideonline.com) : Caitlin Giddings hat ihr Hobby zum Beruf gemacht und hat sehr lange Velotouren durch die USA geleitet. Dabei hat sie viel über Menschen und über Leidenschaft gelernt. Auch dass es manchmal besser ist, etwas pro bono zu machen anstatt dafür Geld zu verdienen.

- Why Were Medieval Monks So Susceptible to Intestinal Worms? (smithsonianmag.com) : Mittelalterliche Mönche in England hatten deutlich mehr Darm-Parasiten als Normalbürger. Es hängt wahrscheinlich damit zusammen, dass die Mönche ihr Gemüse selber angebaut haben und mit ‘Eigenproduktion’ gedüngt haben.

- Putins Google (republik.ch) : Am Anfang war Yandex ein hippes russisches Tech-Start-up. Dann wurde es zum grössten Propagandainstrument des Kreml. Jetzt versucht das Unternehmen verzweifelt, seine toxischen Produkte loszuwerden und zu seinen Wurzeln zurückzukehren.

- Die Infokrieger (republik.ch) : In der Schweiz basteln sich selbst ernannte «alternative Medien» und Oppositionsblätter nach US-amerikanischen Vorbildern ihre eigene Wahrheit und betreiben einen grossen Aufwand, um diese unter die Menschen zu bringen. Eine Reise ans Ende der Demokratie in zwei Teilen.

- The Real Reason Why Are Trucks Getting Bigger (toddofmischief.blogspot.com) : Trucks in den USA werden nicht nur grösser weil die Schnäbis der Fahrer immer kleiner werden, sondern auch weil es einfacher ist, die staatlichen Vorgaben an den Benzinverbrauch für grosse Autos zu erfüllen.

- He was wrongly linked to a terror cell. Freed after 14 years in jail and prison, he is still paying for America’s fear (sfchronicle.com) : In den Jahren nach 9/11 wurde Hamid Hayat zu Unrecht wegen Terrorismus verurteilt und hat alles verloren. Jetzt versucht er, sich selbst zu finden.

- Die rechtsalternativen Verschwörungsfantasien von „Call of Duty“ (belltower.news) : Die erfolgreiche Shooter-Serie ist mit ihrem aktuellen Teil „Cold War“ von mal mehr, mal weniger cleverer Provokation endgültig in Revisionismus und rechtsalternatives Verschwörungsraunen abgedriftet.

- What Bullets Do To Bodies (highline.huffingtonpost.com) : Die Waffendebatte (nicht nur in den USA) würde sich sofort ändern, wenn ‘Unbeteiligte’ die Schrecken erleben würden, mit denen Medizinier:innen täglich konfrontiert sind.

- Disaster at 18,200 feet (businessinsider.com) : Bergsteiger:innen brauchen ein gutes Ego. Ein zu gutes Ego kann aber ganz schnell zu unguten Situationen (nicht nur am Berg) führen.

- Andart: Torus–Earth (aleph.se) : Sehr, sehr, sehr ‘harte’ Science-Fiction. Sehr, sehr cool

- Location in the Visual World (worldbuilder.substack.com) : Christopher Beddow1 schreibt über Verortung in der realen Welt.

- What Happens When a Reservoir Goes Dry? (practical.engineering) : Völlig pragmatische Beschreibung was passiert wenn wegen Wassermangel Reservoire austrocknen oder trocken bleiben.

- Inside the Deadly Campaign of Terror Over Coveted Instagram Handles (businessinsider.com) : Wie bitte? Tote wegen cooler Instagram-Handles? Echt jetzt? Das war so in etwa meine Reaktion als ich diesen Text gelesen habe.

- How Istanbul Became the Global Capital of the Hair Transplant (gq.com) : Istanbul ist eine schöne Stadt, der Author dieses Textes hat aber nicht viel davon gesehen. Wenigstens hat er jetzt wieder volles Haar.

- VanMoof’s Team of ‘Bike Hunters’ Succeeds Where the City Doesn’t (sfstandard.com) : Die VanMoof eBikes kommen mit eingebautem GPS-Tracker. Wenn so ein Velo gestohlen wird, sind die Velojäger von VanMoof amigs flinker als die Polizei.

- A plane of monkeys, a pandemic, and a botched deal: inside the science crisis you’ve never heard of (motherjones.com) : Experten warnen vor einen gravierenden Mangel an Primaten für die biomedizinische Forschung. Die Story hier dazu zeigt, wie kompliziert es sein kann, zu versuchen mit Forschung Menschenleben zu retten.

- We’re Not Going Back to the Time Before Roe. We’re Going Somewhere Worse (newyorker.com) : Ich werde nie mehr eine Schwangerschaft direkt miterleben 2, aber was das Urteil des Supreme Court in den USA für die Kriminalisierung von Schwangerschaften bedeutet, ist nur schwer zu erfassen. Das Recht auf Abtreibung ist ein wichtiges, schauen wir, dass es in der Schweiz so bleibt.

- The man who built his own cathedral (theguardian.com) : Justo Gallego Martínez hat in den letzten fast 60 Jahren ausserhalb von Madrid an einer Kathedrale gebaut. Ende November 2021 ist er verstorben. Sein Bauwerk bleibt und ist eindrücklich.

- My awakening moment about how smartphones fragment our attention span (idratherbewriting.com) : Über die Probleme im Zusammenhang mit Aufmerksamkeits-Spanne und Smartphones. Ich persönlich bin beim ‘Stop reading the news’-Punkt. Und arbeite an weiteren Schritten.

- All the Best Things About Europe with None of the Genocide (lauriepenny.substack.com) : Laurie Penny schreibt über den Eurovision Song Contest. Tönt erstmals danach als müsste mensch den Text unbedingt vermeiden. Aber macht es nicht, sondern lest das Teil.

- „Wir dachten, man könne sich mit Qualität durchsetzen“ (wissenschaftskommunikation.de) : Nach viereinhalb Jahren stellt das Schweizer Wissenschaftsmagazin higgs.ch den Betrieb ein. Ich werde es feste vermissen.

- Fairphone: Der Preis des Wachstums (daslamm.ch) : Das Lammn hat eine längere Serie zum Fairphone gemacht, Teil 1, Teil 2, Teil 3 hier und Teil 4 sind sehr lesenswert. Und zeigen, wie schwer es ist, ein wirklich fair produziertes Smartphone herzustellen.

Im letzten Monat sah ich folgende Videos und fand diese gut:

Unglaublich elegante Art und Weise, 3D-Visualisierungen zu machen.

Brauch ich grad’ fürs nächste Manuskript :)

Eine kleine Lerneinheit über Bildkompression.

Wenn ich mal eine Gartenschaufel brauche, dann bestelle ich die bei Zion Industrial Co.

Recommended Readings vom Juni 2022

Im letzten Monat las ich folgende Texte und fand diese gut:

- Meet the Peecyclers. Their Idea to Help Farmers Is No. 1. (nytimes.com) : Der Mangel an chemischen Düngemitteln, der durch den Krieg in der Ukraine noch verschärft wurde, lässt die Landwirte verzweifeln. Zufälligerweise enthält menschlicher Urin genau die Nährstoffe, die die Pflanzen brauchen.

- Cool desktops don’t change (tylercipriani.com) : Neuerdings schreibe ich ja viel mit VS Code, aber

vibrauche ich für fast jedes Mail. - Platte Pneus: Nicht nur die Aktivist*innen brechen das Gesetz (daslamm.ch) : Immer öfters wird bei SUVs im Namen des Klimaschutzes die Luft aus den Pneus gelassen. Die Polizei rät den Betroffenen zu einer Anzeige. Doch wenn es um grosse Autos geht, sind die Lüftlerinnen nicht die Einzigen, die sich nicht an das Gesetz halten. Auch die Autohändlerinnen müssen millionenstarke Sanktionen bezahlen.

- Interland: The Country In The Intersection (maximumprogress.substack.com) : Eine Möglichkeit, ein Land und dessen Regeln entstehen zu lassen.

- Die Hindelbank-Gespräche (republik.ch) : Einst thronte der Schultheiss von Bern auf dem Hügel über Hindelbank. Heute steht dort eine Haftanstalt. Die Geschichte des grössten Frauengefängnisses der Schweiz – und Einblicke, präsentiert von den Insassinnen selbst.

- Installing a payphone in my house (bert.org) : Ein Publiphone zuhause an der Wand. Wieso nicht?

- Birds Aren’t Real, or Are They? Inside a Gen Z Conspiracy Theory. (correctiv.us12.list-manage.com) : Eine Verschwörungstheorie generieren um Verschwörungstheorien zu entlarven. Sehr cool.

- New Look, Same Great Look (laphamsquarterly.org) : Die Geschichte der Menschheit anhand der Farbfotografie. Oder so.

Im letzten Monat sah ich folgende Videos und fand diese gut:

Garagen-Wissenschaft FTW! Wunderschöne Röntgen-Zeitrafferaufnahmen einer Pflanze.

Die sog. ‘pumpkin toadlets’ sind so klein, dass ihr Gleichgewichtsorgan nicht mehr richtig funktioniert.

Deshalb können sie zwar froschig gumpen, aber nicht so gut landen.

Sehr lustig.

Quasi Groundhog Day, aber chli anders.